apprentissage_par_renforcement_d_un_pendule_de_furuta

Ceci est une ancienne révision du document !

Table des matières

Apprentissage par renforcement d'un pendule de Furuta page à revoir complétement

Cette page fait suite à Intelligence du Pendule de Furuta Affichage de l'efficacité d'un apprentissage par renforcement

Ressources

- Notre

Intelligenceapprentissage statistique furuta sur github

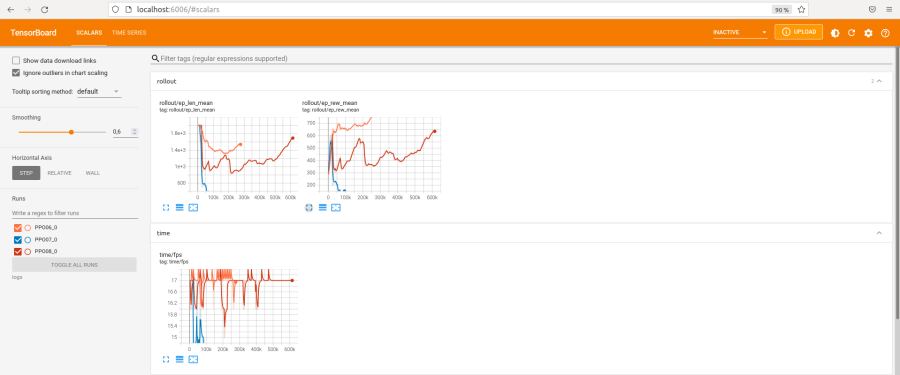

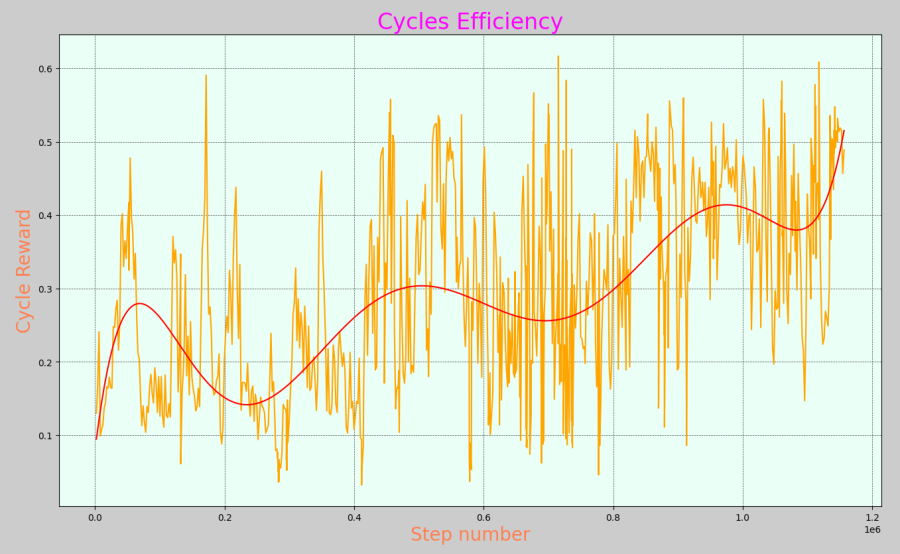

Suivi de l'efficacité de l'apprentissage avec tensorboard

Installation, utilisation

tensorboard est dans les requirements.

Voir train_test.py pour l'implémentation.

Dans le dossier du projet, qui contient le venv=mon_env, lancer en terminal:

./mon_env/bin/tensorboard --logdir=logs

Dans un navigateur:

http://localhost:6006/

Des exemples

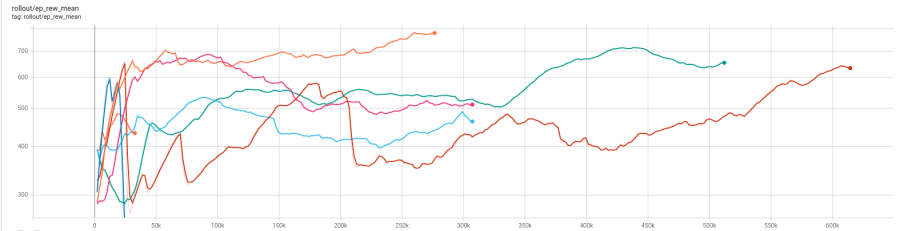

Moyenne des récompenses

Tableau d'Optimisation des Paramètres du Pendule de FURUTA

| Numéro | 06 | 07 | 08 | 09 | 10 | 11 | 14 | 15 |

|---|---|---|---|---|---|---|---|---|

| Learning Rate en 10-4 | 10 | 50 | 20 | 20 | 7 | 12 | 3 | 8 |

| Ent Coef en 10-3 | 1 | 1 | 1 | 2 | 1 | 1 | 0 | 1 |

| Vf Coef | 0.55 | 0.55 | 0.55 | 0.55 | 0.51 | 0.55 | 0.5 | 0.55 |

| Nombre de steps | 276 000 | 82 000 | 614 000 | 307 000 | 307 000 | 512 000 | 307 000 | 1 000 000 |

| Note d'efficacité sur 10 | 6 | 0 | 3 | 1 | 2 | 5 | 5 |

Le nombre de steps doit être d'au moins 1 millions pour commencer à noter la rapidité d'un apprentissage L'apprentissage par renforcement passe par des phase de progrès et de chaos. Ces chaos permettent d'explorer tous les situations. La récompense est le produit de la récompense du chariot par la récompense du balancier. Il faut beaucoup de temps pour que le model intègre cette notion.

On peut faire dire n'importe quoi aux chiffres

apprentissage_par_renforcement_d_un_pendule_de_furuta.1653419063.txt.gz · Dernière modification : 2022/05/24 19:04 de serge